Benchmark des Plateformes de Gestion de la…

Les nouvelles technologies opèrent chaque jour davantage la transformation digitale des entreprises, et conduisent à des modifications structurelles de leur fonctionnement, leur organisation, leurs processus et le pilotage de leur performance.

L’augmentation conjointe du volume, de la variété et de la vélocité de l’information, caractérisant le Big Data, renforce les exigences des différents niveaux de management vis-à-vis de la fonction finance pour disposer des bonnes informations aux bons moments afin de prendre les bonnes décisions.

Comme nous l’avons introduit dans l’article 1 de cette série, la fonction finance doit devenir plus agile et baisser la garde face aux nouvelles technologies afin d’embrasser les fonctions attendues de ses principaux clients : être le Business Partner de la Direction Générale et des Métiers et s’imposer comme la référence principale dans l’aide à la prise de décision.

Autrement dit, la fonction finance doit digitaliser ses processus de reporting et également de prévisions.

La dimension des données exploitables dans le cadre du processus de reporting notamment, a connu une évolution exponentielle, conséquence du développement « tous azimuts » des technologies numériques. Les organisations ont toujours été désireuses de connaitre au mieux leur marché, les bénéficiaires de leurs produits ou services, et l’impact de leurs décisions. Les données qui matérialisent cette connaissance sont désormais accessibles mais comme le montre le schéma ci-dessous, elles sont devenues de moins en moins structurées et relationnelles, de plus en plus complexes et protéiformes.

La fonction finance doit donc élargir le cadre de sa collecte de données pour capter davantage que les informations financières (CA, trésorerie, …) et non financières (nombre de produits vendus, tonnes de matières premières achetées, …) classiques stockées dans ses systèmes d’information internes. Pour optimiser ses reportings, elle peut s’aider des nouveaux leviers digitaux permettant la collecte et l’exploitation d’informations disponibles à l’intérieur et à l’extérieur de l’organisation.

D’une part, le développement des objets connectés génèrent des opportunités quasi-infinies de récolte de données. Le web 3.0 de l’internet des objets (Internet of Things) permet en effet la collecte de données du monde physique vers les réseaux de l’organisation. Ces nouvelles données glanées au plus près des outils de production ou du consommateur participent à l’amélioration de la qualité des reportings issus de leur analyse, et laissent envisager la production automatisée d’indicateurs très difficiles à calculer jusqu’à lors.

D’autre part, afin d’optimiser la connaissance de l’écosystème dans lequel évolue une organisation, de plus en plus de fournisseurs de webservices proposent des accès illimités à des sources de données externes. C’est le cas par exemple de Qlik et de son Datamarket qui offre aux entreprises l’accès à des bibliothèques complètes de données externes moyennant un abonnement. Ceci permet pour une organisation d’enrichir et de contextualiser son reporting en réalisant des croisements entre ses données internes et une variété croissante de données externes. Ces dernières sont principalement des informations gratuites issues de l’open data comme par exemple les données météorologique ou les bilans financiers détaillés des entreprises cotées en bourse. Le reporting est alors connecté à des flux d’information externes en temps réel (météo, taux de change, cours de matières premières, démographie) pour mieux prévoir et anticiper les besoins en ressources ou impacts sur les activités de l’entreprise.

Cette expansion rapide de la quantité de données numériques collectées complexifie la transformation digitale d’une organisation. Le Big Data fournit en effet un ensemble si vaste de données qu’il est de plus en plus difficile de les traiter aux moyens de technologies « traditionnelles ».

L’évolution des systèmes d’information dans les organisations, en participant à la transformation automatique des données préalable à leur exploitation efficace, doit alors apparaître comme un élément stratégique dans l’optimisation du processus de reporting.

La recherche se tourne dans un premier temps sur la capacité d’analyse des données par les nouvelles technologies. Le passage du Big Data vers le Smart Data se fait notamment au moyen d’outils d’analyse de plus en plus accessibles et puissants issus de la Business Intelligence (BI).

Il existe aujourd’hui un certain nombre de solutions BI de ce type sur le marché. Les grands éditeurs tels que Microsoft, IBM, Oracle et SAP, possèdent leurs propres produits exclusifs très implantés parmi les grandes entreprises. Toutefois, ces suites de BI étant relativement coûteuses, surtout pour les petites entreprises, de plus en plus d’alternatives en open source tirent leur épingle du jeu. On peut citer par exemple BIRT (Business Intelligence & Reporting Tools), Pentaho, JasperReports Server ou encore SpagoBI. Licenciés sous GPL, ces outils sont principalement utilisés par les petites et moyennes entreprises, mais certains sont de plus en plus adoptés parmi les grandes organisations. Quoiqu’il en soit, le secteur est extrêmement dynamique et nécessite une veille active de la part des entreprises pour mettre à profit les évolutions technologiques indispensables à l’exploitation des données.

Le deuxième axe stratégique de l’évolution des systèmes d’information dans la transformation des données porte sur le délai d’obtention de l’information traitée et donc la récence des analyses. Traditionnellement, les outils BI avancés utilisaient une approche consistant à transférer les données des entrepôts de données vers une application tierce pour obtenir les analyses. Ce type d’architecture présente l’inconvénient d’engendrer des latences en raison du déplacement des données, et l’augmentation du volume d’information intensifie ces désagréments tout en fragilisant le modèle d’analyse.

Un changement de paradigme s’opère actuellement pour tenter de pallier à ces fragilités. Microsoft par exemple propose aujourd’hui avec son nouveau server SQL 2016, de déplacer l’analyse des données à proximité de l'endroit où elles sont stockées, dans le Datawarehouse. Ainsi les calculs, les croisements ou encore les agrégats sont réalisés de manière sécurisée dans la base de données elle-même sans déplacer les données, ce qui permet d'analyser les transactions en temps réel avec d’excellents temps de réponse par rapport aux volumes de données.

L’enjeu majeur des process de reporting est donc d’intégrer les nouveaux outils SI du marché afin de maîtriser les complexités du Big Data et d’en tirer les plus grandes opportunités : le smart Data. Cette intelligence dans La gestion et l'analyse des données ne peut alors être efficace comme outil d’aide à la décision que si le fruit de son analyse est correctement communiqué, diffusé et utilisé dans toute l'organisation.

La fonction financière cherche depuis la mise en place des premiers ERP à automatiser le traitement et la diffusion des données pour se consacrer d’avantage à leur analyse. Elle s’approche de la concrétisation de cet objectif grâce à la digitalisation des processus de pilotage. Ainsi le contrôleur de gestion se détache enfin de la production des tableaux de chiffres pour se concentrer sur la signification, l’analyse et la représentation de ses chiffres.

Les nouveaux outils de data visualisation permettent cette compréhension du sens de l'information, et sont un instrument de communication. Ils se situent donc au juste milieu entre la présentation purement technique et l'ergonomie pour faciliter le passage du sens.

Les éditeurs BI sont de plus en plus nombreux à permettre aux profils non techniques de construire de façon intuitive et accessible des représentations graphiques très élaborées. Tableau par exemple, leader sur ce marché selon Gartner, propose aux utilisateurs métier d'explorer ses données dans un environnement fiable, sans les limiter avec des assistants ou des types de graphiques prédéfinis. Les autres outils principaux du marché sont fournis par Qlik, Microsoft (Power BI), SAS ou encore Alteryx.

Ici encore le cloud et les solutions en Saas sont privilégiés, car ils répondent parfaitement au besoin de partage de l’information instantanée, ainsi qu’à la rapidité d’intégration des évolutions technologiques. Tout d’abord, les reportings sont disponibles sur tous les supports (PC, tablette, mobile, …), donc accessibles partout et tout le temps. Par ailleurs, la diffusion et le partage des analyses et reportings ne sont plus limités par des problématiques chronophages (mise en forme bureautique, envoi par mail, traduction, …) et la collaboration est rendue possible directement faisant des analyses et commentaires des données dynamiques intégrées aux tableaux de bord. Enfin, cela permet le stockage et la mise à jour en temps réel des données internes et externes à l’entreprise, pour tous les collaborateurs.

En d’autres termes, cela répond aux attentes d’agilité, de simplicité et d’exhaustivité souhaitées aujourd’hui par les destinataires de reportings.

Ce type de solutions est donc incontournable pour toute fonction finance souhaitant jouer le rôle de Business partner aguerri, suivant les avancées technologiques, tout en gérant les risques et le respect de la règlementation. Nous avons essentiellement évoqué le sujet du reporting mais ces mêmes fonctionnalités sont tout aussi essentielles à la digitalisation des processus prévisionnels, en particulier l’exploitation de données externes et les fonctionnalités de collaboration.

Une fois que l’automatisation des tâches de production et diffusion du reporting financier sera acquise dans les organisations, les directions financières pourront porter leurs efforts sur le développement des capacités d’anticipation, d’estimation et d’autoanalyse de leurs outils SI. Nous évoquons ici la mise à profit de fonctionnalités prometteuses que peuvent apporter l’Intelligence Artificielle et le Machine Learning.

Dotée d’outils d’analyse prédictive, les Directions Financières auront en effet la possibilité d’anticiper les évolutions et les tendances aussi rapidement et justement que possible. Elles seront en mesure d’aider les Métiers à anticiper leurs besoins en fonction de l’évolution de la conjoncture, ou encore de prédire les comportements ou événements pour augmenter la rentabilité de l’entreprise (anticipation des défaillances clients, détection de fraude, etc.).

Les plateformes d’intelligence artificielle telles que Watson (IBM), Holmes (Wipro) ou Mana (Infosys), offrent des perspectives prometteuses en matière d’exploitation intelligente des Big Data. Ces plateformes ont la capacité d’apprendre - « machine learning » - au contact de nouvelles données pour ainsi être en mesure de proposer et affiner des scenarios prédictifs élaborés. D’autres cas d’usage peuvent également être imaginés : un assistant virtuel dédié à la Finance répondant aux questions des opérationnels, l’explication instantanée de ratios, la comparaison financière contextualisée, etc.

La digitalisation du processus de reporting financier est en marche dans les organisations depuis plus de deux décennies, et semble enfin connaître une véritable accélération. Les possibilités, chaque jour plus importantes, qu’apporte une exploitation intelligente et automatisée des données financières, opérationnelles, internes et externes en font un enjeu stratégique, et nécessite des adaptations des ressources humaines pour y répondre au mieux. Le défi est alors d’anticiper ces transformations en terme organisationnel : comprendre dès aujourd’hui les rôles et responsabilités des financiers de demain, adapter les organisations, et investir dans les nouvelles compétences nécessaires pour optimiser le pilotage financier, en particulier vis-à-vis des outils digitaux.

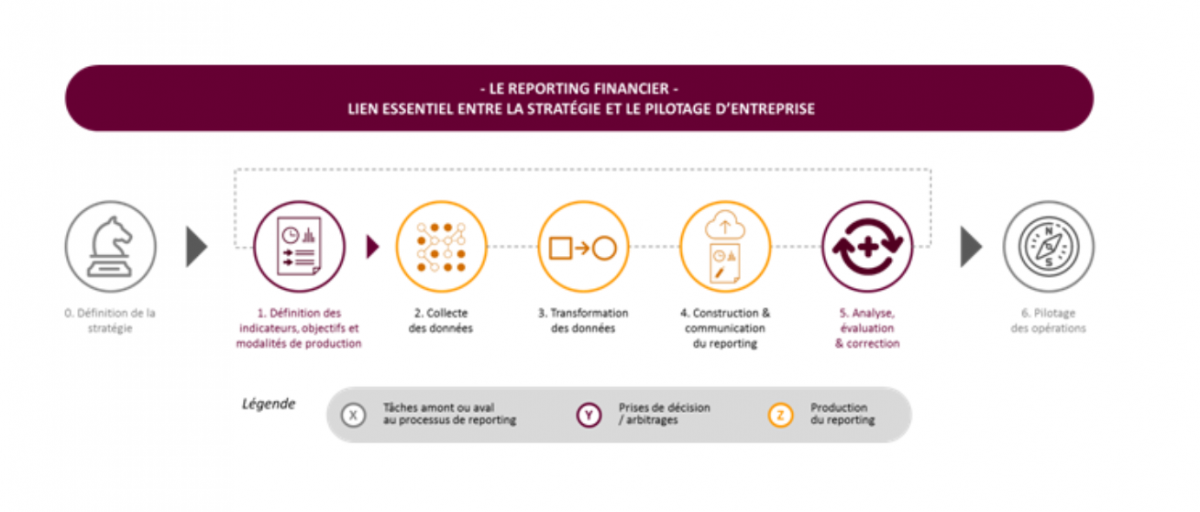

Pour continuer votre lecture sur la thématique « Repenser le reporting financier », nous vous invitons à lire le premier article : Repenser le reporting financier : redonner du sens au processus de reporting.