Observatoire international des e-fuels, édition…

La technologie est faillible.

La panne d’électricité qui survint le 11 janvier 2018 dans les halls du CES[1], plus grand salon mondial consacré à l’électronique, en est une illustration cocasse. Lors de cette grand-messe des innovations, qui promeut chaque année les technologies du monde de demain, une coupure de courant a plongé tout le monde dans le noir pendant plus de deux heures.

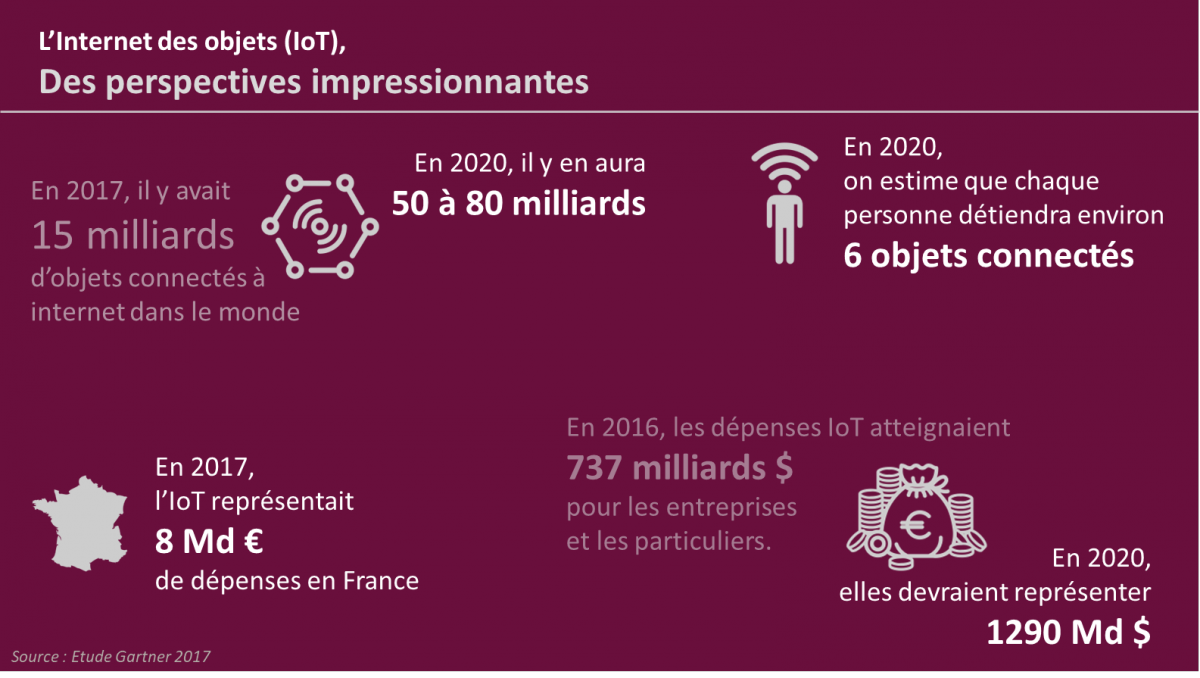

Alors que le salon faisait encore une fois la part belle à l’Internet des Objets, ou Internet of Things (IoT), cette panne nous ramène à l’impossible infaillibilité des objets. Elle nous interroge aussi sur les défis juridiques et réglementaires posés par l’IoT, l’Intelligence Artificielle (IA) qu’ils peuvent posséder et les serveurs informatiques sur lesquels ils s’adossent.

Ce marché en pleine explosion va révolutionner le rapport entre le monde physique et le monde numérique. La multiplication de ces objets connectés fascine et interroge, semblant n’avoir pour seule limite que celle que notre cerveau humain ne peut concevoir : le machine learning (capacité d’une intelligence artificielle à apprendre d’elle-même) repousse les frontières du champ des possibles. Tous les aspects de nos vies pourront potentiellement être impactés par de nouveaux produits et services.

Alors le potentiel et les impacts de l’IoT – notamment sa capacité à influer sur le monde physique – s’apparentent à un transfert de responsabilité dont les contours précis ne sont pas encore définis. La réflexion à ce sujet est essentielle dans l’optique de bâtir un IoT responsable et performant. Elle ne peut se cantonner au désormais classique dilemme de la voiture autonome : en cas de collision imminente, doit-elle tuer le piéton ou sacrifier les passagers ? Elle dépasse ce simple questionnement et implique deux interrogations majeures :

Si la responsabilité de l’acte humain semble se diluer dans l’objet connecté qui le remplace ou le complète, peut-on vraiment dire d’un objet connecté qu’il est « responsable de ses actes » ?

La confiance dans l’IoT et a fortiori l’IA n’est-elle pas un sujet de société avant d’être un débat de juristes ?

Le premier axe de réponse est juridique. Face à ces questions de responsabilité à la suite d’un dommage causé par un objet connecté, le droit français est face à une zone d’ombre.

Cette incertitude n’est pour autant pas un vide puisque la responsabilité dite civile, relative au dommage causé par un objet est établie par l’article 1242 du Code Civil : « on est responsable non seulement du dommage que l’on cause par son propre fait, mais encore de celui qui est causé par le fait des personnes dont on doit répondre ou des choses que l’on a sous sa garde ». Pratiquement, on peut imaginer le dommage causé par un drone percutant et brisant une fenêtre qu’il n’aurait pas détectée, un robot chirurgien qui confond deux organes ou un véhicule autonome qui percute un cycliste par exemple. Les cas pratiques sont multiples.

Mais qu’est-ce que la garde d’une chose en droit ? Le texte de projet de réforme de la responsabilité civile présenté le 13 mars 2017[2] apporte un éclairage tout particulier et consacre les dispositions jurisprudentielles qui avaient défini trois critères pour la garde. Ledit projet d’article 1243 dispose : « le gardien est celui qui a l’usage, le contrôle et la direction de la chose au moment du fait dommageable. Le propriétaire est présumé gardien. »

Mais comment concevoir alors que l’utilisateur d’un objet connecté qui a été pour partie dépossédé de son pouvoir de contrôle et de direction du fait de l’autonomie plus ou moins grande de l’objet puisse être responsable de sa défaillance ou du dommage causé ? Les objets connectés sont des choses spéciales qui disposent souvent d’une véritable autonomie et dont la notion de contrôle peut ainsi être remise en cause.

Juridiquement, la victime du dommage peut aussi agir contre le fabricant de l’objet. Et ce, en se basant sur le fondement de la responsabilité des produits défectueux. A ce titre, l’article 1245 du Code Civil dispose que : « le producteur est responsable du dommage causé par un défaut de son produit, qu’il soit ou non lié par un contrat avec la victime ». L’article semble favorable à la victime. Le patient qui a subi l’ablation du mauvais organe par exemple pourrait se retourner contre le fabricant du robot chirurgien en cause.

Mais dans le cas de l’IoT, comment définir le défaut de l’objet connecté ? L’article 1245-10 du Code Civil dresse la liste des états de fait qui permettent d’exonérer le producteur de sa responsabilité : la loi affirme que le défaut ne peut pas être postérieur à la mise en circulation de l’objet et écarte la responsabilité de plein droit du producteur lorsque l’état des connaissances scientifiques et techniques au moment où le produit a été mis en circulation ne permet pas de déceler le défaut du produit par exemple.

Or l’objet connecté « apprend » et s’adapte aux comportements de son utilisateur. Le « défaut » peut donc être l’effet d’un apprentissage que l’état des connaissances scientifiques au moment où l’objet a été vendu ne permettait pas d’anticiper. Le caractère intrinsèque d’un tel objet, qui est d’être « connecté » rend donc difficile l’application d’un tel article puisque son fabricant pourra aisément se prévaloir de l’article 1245-10 pour s’exonérer de toute responsabilité.

L’incertitude juridique est réelle, et le projet de réforme n’éclaircit pas le flou qui entoure ces notions de responsabilité. Même si la Commission Européenne a suggéré en 2017 de créer un statut juridique spécial pour les « personnes électroniques » et les robots[3], la question n’est toujours pas tranchée et est actuellement incompatible avec une généralisation de l’IoT dans nos sociétés.

Certes, l’internet des objets n’en est qu’à ses balbutiements. Mais aucun pays n’a pour l’instant édicté de cadre juridique clair, peut-être pour ne pas brider l’innovation. Le droit semble jouer la montre – et ce, dans tous les pays – et ce sont donc les industriels qui font parfois le premier pas : Google, Volvo et Mercedes par exemple ont déjà affirmé qu'ils accepteront de prendre la responsabilité juridique en cas d'accident causé par leur voiture autonome[4].

Le droit semble ainsi avoir un pas de retard sur l’innovation et ceux qui la créent. Doit-on laisser à l’IoT le soin de s’auto-encadrer ? N’est-ce pas prendre le risque d’une réaction disproportionnée du législateur après un accident médiatisé impliquant un de ces objets connectés ?

Cette question revient finalement à ouvrir le débat sur une interrogation plus large : quelle est la place que nous voulons donner à l’IoT, et plus largement à l’IA, dans nos sociétés ?

A cet égard, la CNIL en 2017 s’est interrogée sur les enjeux des algorithmes et de l’intelligence artificielle[5] : « comment permettre à l’homme de garder la main » dans une société où la technologie et les objets connectés sont voués à prendre une place sans doute considérable ? Ce document, synthèse du débat public animé par la CNIL dans le cadre de la mission de réflexion éthique confiée par la loi pour une république numérique comprend les promesses qu’offre ce nouveau potentiel. Mais il propose de l’encadrer par deux grands principes : la loyauté et la vigilance/réflexivité.

Ces deux principes sont aisément transposables pour l’IoT. D’abord, l’objet connecté ne doit pas trahir son utilisateur et s’il apprend, il doit respecter le cadre posé en amont. Ensuite, conscient de la dilution de la responsabilité qu’impliquent ces nouvelles technologies, il convient de questionner régulièrement la fabrication et l’usage de l’objet pour minimiser le biais cognitif qui conduirait l’humain à accorder une confiance trop importante à l’algorithme. En effet, l’objet est potentiellement faillible et imparfait : l’utilisateur doit toujours en avoir conscience. L’usage des objets connectés qui n’est pas bridé par un carcan réglementaire doit néanmoins s’inscrire dans le cadre d’un processus décisionnel réel : un cadre qui nécessite de réfléchir le projet IoT sur le long-terme, de négocier avec les partenaires et d’accompagner sa mise en œuvre de bout en bout.

Ces deux principes (loyauté et vigilance) permettent le développement contrôlé de l’IoT et de l’IA sans circonscrire leurs capacités par un cadre juridique trop restreint. Ces principes, très théoriques au premier abord doivent être conjugués opérationnellement lors du déploiement à l’échelle du local de projets qui impliquent de l’IoT et de l’IA.

A ce titre, il semble pertinent d’ajouter une vision générale à cette réflexion portée par la CNIL : le principe d’indépendance. Plus que d’être vigilant, l’humain doit s’efforcer de cultiver une certaine indépendance vis-à-vis de l’IoT et de l’IA en général. L’indépendance n’est pas l’indifférence, mais l’indépendance maintient la responsabilité dans le giron humain. Elle sous-tend un effort de formation conséquent pour éveiller les utilisateurs aux risques qu’impliquent ces objets intelligents et pour maintenir leur niveau de maîtrise. L’application de ces trois principes nécessite d’accompagner les grands acteurs publics et privés sur :

La mise en œuvre opérationnelle de cette intelligence connectée à travers les perspectives qu’ouvrent la Smart City, les véhicules autonomes ou l’e-santé exige un cadre qui, sans être immédiatement réglementaire, doit être éthique et stratégique. L’Internet des objets demeure une opportunité pour les entreprises, les acteurs publics et les particuliers tant que la dynamique s’inscrit dans une volonté forte qui comprend les promesses et exige des limites. Loyauté, vigilance et indépendance. Telle est la vision stratégique qui loin de tourner le dos à l’innovation accueille intelligemment ce nouveau potentiel qu’est l’IoT. Le droit suivra.